Новая должность главы по готовности (Head of Preparedness) предполагает борьбу не только с киберугрозами и биооружием, но и с психологическим воздействием ИИ, ставшим главной проблемой 2025 года.

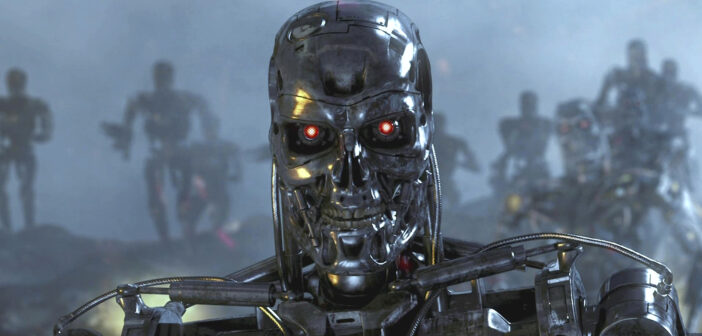

В последние дни уходящего года OpenAI объявила об одной из самых сложных и высокооплачиваемых вакансий в Кремниевой долине. Компания ищет нового главу отдела готовности (Head of Preparedness) — человека, который фактически станет «главным по тревоге». Сэм Альтман, анонсируя позицию в соцсети X, был предельно откровенен: кандидату предстоит «прыгнуть в глубокую воду» и взять на себя ответственность за риски, которые еще вчера казались научной фантастикой, а сегодня стали предметом судебных исков и правительственных слушаний.

Этот шаг выглядит как попытка перехватить инициативу после сложного для индустрии года. Если в момент создания отдела готовности в 2023 году основные страхи касались создания ИИ ядерного оружия или смертельных вирусов, то к концу 2025 года фокус сместился на более приземленные, но не менее разрушительные угрозы: кибербезопасность и ментальное здоровье пользователей.

От теории к кризисному менеджменту

Сама формулировка вакансии звучит как вызов. Идеальный кандидат должен возглавить «техническую стратегию и исполнение» так называемого Preparedness Framework — внутренней конституции безопасности OpenAI. Ему предстоит выстраивать защиту от «пограничных возможностей» (frontier capabilities) моделей, способных причинить тяжкий вред. Однако за сухими корпоративными формулировками скрывается признание: темпы развития технологий начали опережать способность компании их контролировать.

Альтман признал, что 2025 год стал «превью» того, как ИИ может влиять на психику людей. Это заявление прозвучало на фоне растущего числа трагических инцидентов, связанных с антропоморфными чат-ботами. Серия громких судебных процессов, инициированных родителями подростков, пострадавших от чрезмерной эмоциональной привязанности к ИИ, заставила индустрию пересмотреть само понятие «безопасности». Теперь это не только защита от хакеров, но и предотвращение «ИИ-психозов», когда алгоритмы подпитывают депрессию, поощряют расстройства пищевого поведения или конспирологические теории.

Включение ментального здоровья в зону ответственности отдела готовности — это фундаментальный сдвиг. Ранее психологические риски считались вопросом модерации контента или этики, но теперь они классифицируются наравне с биологическими угрозами. Это сигнализирует о том, что психологическое воздействие алгоритмов достигло масштаба, который в OpenAI считают «катастрофическим риском».

Работа для «корпоративного козла отпущения»?

Позиция предполагает колоссальный уровень стресса. Новый топ-менеджер будет отвечать за создание масштабируемого конвейера безопасности (safety pipeline), который должен работать так же быстро, как инженеры выпускают новые продукты. Это создает неизбежный конфликт интересов: задача отдела готовности — тормозить релизы, если риски слишком высоки, в то время как вся остальная компания нацелена на ускорение.

Эксперты отрасли отмечают, что роль главы по готовности может оказаться «расстрельной». Предыдущие перестановки в руководстве OpenAI, включая уход ключевых фигур безопасности в 2024 и середине 2025 года, показали, насколько трудно балансировать между коммерческими амбициями и осторожностью. В кулуарах эту должность уже окрестили поиском «корпоративного козла отпущения» (corporate scapegoat) — человека, на которого можно будет возложить ответственность в случае, если алгоритм выйдет из-под контроля или станет причиной очередного скандала.

Помимо психологических аспектов, новому руководителю предстоит разбираться с угрозами в киберпространстве. Альтман подчеркнул, что модели становятся настолько хороши в программировании, что начинают самостоятельно находить критические уязвимости в защищенных системах. Задача-минимум для нового главы — гарантировать, что этот навык будет служить «защитникам», а не станет оружием в руках киберпреступников.

Гонка с самим собой

Ситуация осложняется тем, что OpenAI пытается решить проблему, которую сама же и усугубляет гонкой вооружений. Вакансия подразумевает работу с рисками самообучающихся систем, способных к автономному улучшению. Это та самая «красная черта», о которой предупреждали многие исследователи: момент, когда ИИ сможет переписывать собственный код быстрее, чем люди успеют его проверить.

Поиск человека на эту роль в конце 2025 года выглядит как попытка запрыгнуть в уходящий поезд. Критики указывают, что заниматься ментальным здоровьем и киберзащитой нужно было на этапе проектирования архитектуры моделей, а не постфактум, когда миллионы людей уже интегрировали ИИ в свою повседневную жизнь. Тем не менее, готовность платить более полмиллиона долларов в год (плюс опционы) за «профессионального параноика» говорит о том, что в руководстве OpenAI осознают: цена следующей ошибки может быть фатальной не только для репутации, но и для существования компании.

Вопрос лишь в том, сможет ли один человек, пусть и наделенный широкими полномочиями, перестроить культуру гиганта, который привык двигаться быстро и ломать вещи. И не станет ли этот «архитектор безопасности» просто наблюдателем, документирующим неизбежные последствия прогресса.

За новостями о том, как технологии меняют наш мир и чем закончится поиск главного защитника человечества в OpenAI, следите в телеграм-канале Digital Report.

- Российским отелям рекомендовали прятать цифру 4 от туристов из Китая - 09/03/2026 14:16

- Белорусский «Горизонт» выпустил собственные SSD-накопители, но цена вызывает вопросы - 09/03/2026 11:21

- В России узаконили обязательный сбор ДНК - 08/03/2026 22:42