Специалисты по машинному обучению знают: успех проекта часто зависит не только от алгоритмов, но и от вычислительных мощностей. Пока одни исследователи ждут неделями результатов обучения на слабом железе, другие получают готовые модели за несколько часов благодаря правильно подобранному GPU. Для многих команд аренда GPU для машинного обучения становится единственным способом конкурировать с крупными технологическими компаниями, имеющими собственные вычислительные кластеры.

Но создание работающей нейронной сети — это не просто загрузка данных и нажатие кнопки «старт». Специалист должен понимать архитектуры моделей, настраивать гиперпараметры, предобрабатывать данные и интерпретировать результаты. Это требует глубоких знаний в математике, программировании и понимания предметной области.

Все эти задачи решает машинное обучение, но их реализация требует серьезной технической подготовки. И все они требуют одного — мощного железа для обработки данных.

Как нейронные сети учатся понимать мир

Процесс обучения нейронной сети похож на обучение ребенка, но в сотни раз сложнее. Представьте, что вы учите систему распознавать кошек на фотографиях. Сначала вы показываете ей тысячи изображений с кошками и говорите: «Это кошка». Потом показываете тысячи фотографий без кошек и объясняете: «Это не кошка».

Но нейронная сеть не просто запоминает картинки. Она выделяет признаки — форму ушей, расположение глаз, текстуру шерсти. Каждый пиксель изображения проходит через множество слоев вычислений. В процессе обучения сеть постоянно корректирует миллионы параметров, чтобы лучше различать объекты.

Специалист по машинному обучению должен правильно подготовить данные, выбрать архитектуру сети, настроить скорость обучения и множество других параметров. Одна ошибка — и модель может учиться месяцами, так и не достигнув нужной точности.

Почему обычный компьютер не справляется

Когда нейронная сеть учится распознавать лица на фотографиях, она выполняет миллиарды простых математических операций. Представьте, что вам нужно посчитать 2+2 миллион раз подряд. Обычный процессор делает это последовательно — сначала одну операцию, потом другую, потом третью.

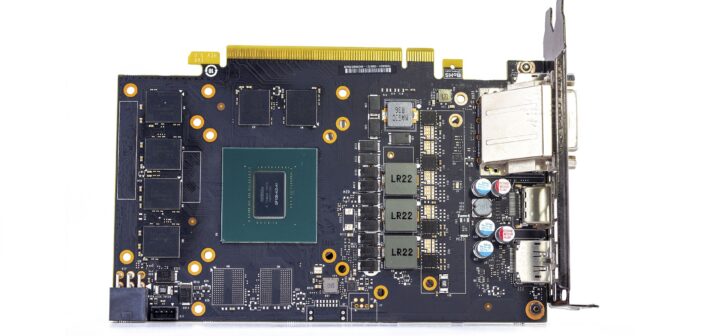

Графический процессор работает иначе. Он как огромная фабрика с тысячами рабочих, где каждый может считать свои 2+2 одновременно. Вместо одного миллиона операций подряд получается тысяча пакетов по тысяче операций каждый — и все параллельно.

Именно поэтому обучение нейронной сети на GPU происходит в 10-100 раз быстрее. То, что на обычном компьютере займет неделю, на правильном GPU делается за час.

Память решает всё

Но скорость — это только половина истории. Вторая половина — память. Современные нейронные сети похожи на очень умных, но рассеянных студентов. Они запоминают огромное количество информации, но должны держать всё в голове одновременно.

Языковая модель, которая пишет тексты, может содержать 175 миллиардов параметров. Каждый параметр — это число, которое нужно где-то хранить. Если GPU не хватает памяти, модель просто не поместится. Как если бы вы пытались записать роман на листочке размером с визитку.

Для простых экспериментов хватает 8-12 гигабайт видеопамяти. Но если вы хотите создать что-то серьезное — скажем, систему автоматического перевода или помощника для врачей — понадобится 24-48 гигабайт или даже больше.

Аренда против покупки

Здесь мы подходим к главному вопросу: покупать собственный GPU или арендовать? Хороший графический процессор для машинного обучения стоит от 50 тысяч рублей до полумиллиона. Плюс нужен подходящий компьютер, система охлаждения, стабильное электричество.

Многие специалисты выбирают аренду GPU для машинного обучения, особенно на начальном этапе. Это как взять машину напрокат для поездки в отпуск вместо покупки собственного автомобиля.

Аренда позволяет экспериментировать с разными типами GPU, масштабировать проекты по мере роста и не тратить огромные деньги на оборудование, которое может устареть через год-два.

Что выбрать из доступного

На рынке доминируют несколько игроков. NVIDIA RTX 4090 — это как Toyota Camry в мире GPU. Надежно, производительно, подходит для большинства задач. 24 гигабайта памяти хватает для серьезных экспериментов.

NVIDIA A100 и H100 — это уже суперкары. Они созданы специально для центров обработки данных и больших проектов. H100 может обучить модель, которая на RTX 4090 будет учиться неделю, за несколько часов.

AMD тоже делает хорошие GPU, особенно серию Instinct. Они часто предлагают больше памяти за те же деньги, что привлекательно для определенных задач.

Как не потратить ресурсы впустую

Даже самый мощный GPU может простаивать без дела, если неправильно организовать работу. Это как купить Ferrari и ездить на нем по пробкам со скоростью 20 километров в час.

Ключ к эффективности — правильная подготовка данных. Пока GPU обрабатывает один пакет информации, следующий пакет должен быть уже готов. Иначе мощный процессор будет ждать, когда компьютер прочитает файлы с диска.

Размер пакета тоже важен. Слишком маленький — GPU не загружается полностью. Слишком большой — не помещается в память. Нужно найти золотую середину.

Зачем это нужно профессионалам

Специалисты по машинному обучению работают в самых разных областях. Data Scientist в банке создает модели для оценки кредитных рисков. Исследователь в медицинском центре обучает нейронные сети диагностировать рак по снимкам. Инженер в автомобильной компании разрабатывает системы для беспилотных автомобилей.

Каждая из этих задач требует не только технических навыков, но и понимания предметной области. Нельзя просто взять готовый алгоритм и применить его к любым данным — нужно знать специфику задачи, особенности данных и требования к результату.

Куда движется индустрия

Производители GPU не стоят на месте. Каждое новое поколение становится мощнее и энергоэффективнее. Появляются специализированные чипы, заточенные именно под задачи искусственного интеллекта.

Интересно, что развитие идет не только в сторону увеличения мощности. Новые архитектуры умнее распределяют нагрузку, экономят энергию и адаптируются под конкретные задачи. GPU будущего сможет автоматически перестраиваться под разные типы нейронных сетей.

Практические советы для ML-инженеров

Если вы работаете с машинным обучением, правильный выбор GPU критически важен для продуктивности. Многие базовые эксперименты можно проводить на обычных видеокартах, но для серьезных проектов нужны профессиональные решения.

Важно понимать специфику своих задач. Обучение языковых моделей требует огромного объема памяти, но может обходиться относительно простыми вычислениями. Компьютерное зрение, наоборот, нуждается в высокой вычислительной мощности для обработки сверточных слоев.

Планируйте ресурсы заранее. Эксперименты имеют свойство разрастаться — модель, которая сегодня помещается в 8 гигабайт памяти, завтра может потребовать 32 гигабайта при увеличении размера датасета или усложнении архитектуры.

Современные инструменты позволяют эффективно использовать облачные ресурсы. Многие исследователи предпочитают арендовать мощности по мере необходимости, а не инвестировать в собственное оборудование, которое может устареть или простаивать между проектами.

- ZeniMax готовит перезапуск Quake - 09/03/2026 16:19

- МВД России раскрыло масштабную схему заражения Android-устройств - 09/03/2026 16:03

- Цифровая вселенная Dota: код, миллионы и бессмертные герои - 09/03/2026 15:59