Голосовой ассистент больше не требует заученных фраз: новая архитектура на базе LLM позволяет управлять электроникой через естественный диалог и составные просьбы.

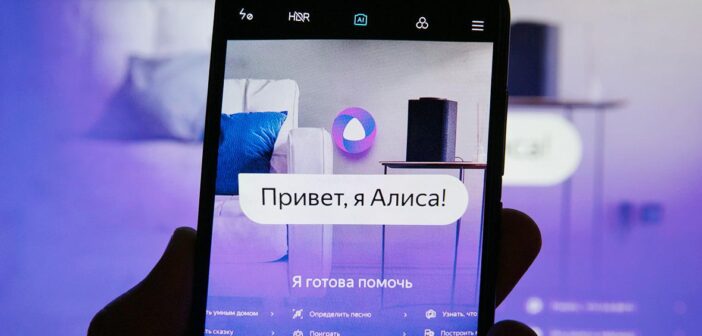

Экосистема умного дома от Яндекса начала масштабный переход от жестких алгоритмов распознавания команд к семантическому пониманию речи. В компании объявили о внедрении технологии tool calling (вызов функций), которая позволяет виртуальному ассистенту Алисе интерпретировать живой язык пользователя и самостоятельно соотносить его с техническими возможностями подключенных устройств. Это обновление знаменует смену парадигмы в управлении домашней автоматизацией: вместо роли оператора, отдающего четкие приказы, пользователь переходит в роль собеседника.

Раньше взаимодействие с голосовыми помощниками часто напоминало игру в «угадай пароль»: если человек использовал формулировку, не прописанную в сценарии, система заходила в тупик. Теперь, благодаря интеграции больших языковых моделей, Алиса анализирует не отдельные ключевые слова, а общее намерение (интент). Яркий пример новой логики — бытовые сценарии. Фраза «Алиса, пора прибраться» больше не требует уточнения «включи пылесос» — нейросеть сама делает логический вывод и запускает робот-пылесос. Аналогично работает управление временем: жалоба «мне завтра нужно встать в семь» автоматически конвертируется в установку будильника, избавляя владельца от лишних подтверждений.

Технически это стало возможным благодаря тому, что модель научилась разбивать абстрактные запросы на конкретные API-команды для гаджетов. Система стала толерантна к синонимам и неточностям, свойственным человеческой речи. Если в приложении комната названа «Гостиная», а пользователь по привычке называет её «Залом», свет включится без ошибок. То же касается и цветовосприятия: просьба зажечь «бирюзовый» свет будет корректно обработана, даже если в технической палитре умной лампочки этот оттенок зашит как «голубой» или «циановый». Ассистент перестал быть формалистом, сверяющим слова со справочником.

Особенно важным шагом стало появление контекстной памяти в управлении устройствами. Ранее диалог с ассистентом обрывался после каждого действия, теперь же система способна удерживать нить разговора. Это открывает возможности для цепочек команд. Например, пользователь может спросить у Алисы: «При какой температуре заваривать черный чай?», получить справку из интернета, а затем просто сказать: «Включи чайник на эту температуру». Нейросеть свяжет найденную информацию (например, 90 градусов) с функцией умного чайника.

Кроме того, технология tool calling решила проблему однозадачности. Раньше для настройки атмосферы приходилось давать две команды подряд: сначала включить лампу, затем отрегулировать яркость. Обновленная модель понимает мультизадачные запросы вроде «Включи желтый свет на сорок процентов», выполняя оба действия одновременно.

На данный момент функция работает в тестовом режиме, но в Яндексе подчеркивают, что это лишь начало глубокой интеграции генеративных нейросетей в быт. По мере обучения на реальных диалогах система будет распознавать все более сложные конструкции, постепенно делая интерфейс «человек-машина» невидимым. Это логичное продолжение стратегии компании: ранее нейросетевые возможности Алисы уже были расширены функцией помощи в интернет-покупках, где ассистент выступает в роли консультанта.

Следите за новостями технологий и обновлениями нейросетей в телеграм-канале Digital Report.

- Роскомнадзор опроверг новости о применении нейросетей для полной блокировки VPN - 02/03/2026 19:03

- Комета 3I/Atlas покидает Солнечную систему с аномальной траекторией - 02/03/2026 18:54

- Роскомнадзор подключил нейросети для удушения зарубежного трафика - 02/03/2026 17:47